今回の 9.3 系では、 我が家で NAS4Free をインストールして使っている GIGABYTE GB-BXCE-2955 に搭載されている ネットワークインターフェイス Realtek 8111G や USB 3.0 インターフェイスをデフォルトで認識してくれます。

Upgrading NAS4Free "Embedded" or "Full" from 9.2 or older to 9.3.0.2 from webgui or from LiveCD/USB is problematic, due a new size of boot partition.この時点ですでにいやな予感はしていました (_ _;>

おまけに Embedded 版の拡張子は .xz に変わっていて、当然、このままだと GUI の管理画面から アップグレードできませんでした。

だったら .gz に変換して読み込ましてやれば…と思ってもやってみるべきではなかった orz

ものの見事に再起動不能に。よい子はまねしないように… (T-T)b

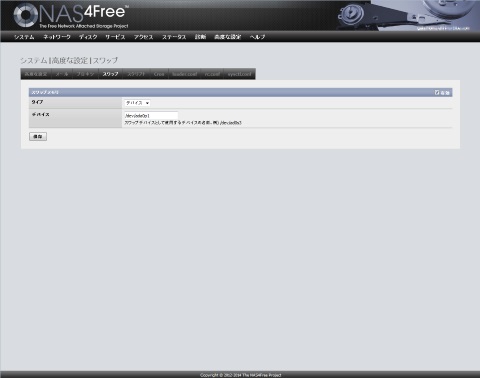

と言うわけで、管理画面からのアップデートはできませんでしたし、 Embedded 版のイメージを解凍して直接、 USB メモリーに転送する方法もとらず、 時間もなかったので一番確実な方法で CD から起動して、素直にインストールし直すことにしました。

事前に設定だけはバックアップしていたもので、 ISO イメージを CD に焼いて、ここから起動して USB メモリーにインストールし直し、 バックアップしておいた設定を読み込ませて再起動。

USB でつないだストレージがある場合、 9.2 系ではシャットダウンプロセスが止まるバグがありましたが、 9.3 ではこれも解消。すばらしい (^^)b

# 皆さんも無茶をするときは必ず設定のバックアップを。。。 少なくとも設定だけはバックアップから問題なくリストアできました。

超すったもんだしましたが、何とかアップグレード完成です!

ネットワークインターフェイスはなんにもせずとも認識し、 USB で外づけているストレージは管理画面で見るかぎりとちゃんと 3.0 で繋がってる!!

紆余曲折があってやっとここまでたどり着きました。って感じで、ちょっと感動を味わっています (T-T)

期待通りのパフォーマンスアップは望めたか? それはもうちょっと使い込んでから報告します ^^