Embedded 版の NAS4Free は 初期状態でスワップが有効になっておらず、 当方ではメインメモリーとして 8GB 搭載していてそうそうメモリー不足に陥ることはないですが、 ちょっと無茶な設定をしたときなど過去数度フリーズしたこともあるので、 120GB と言う容量に余裕のある SSD を増設したため、この際、スワップも有効にすることにしました。

作業は NAS4Free サーバーに SSH でログインしてコマンドラインから root ユーザーに切り替えて作業を行います。

セットアップの終わった SSD は /dev/ada0 として認識しているものとして話を進めます。

まずは新品の SSD ですので、以下のコマンドで GPT で初期化を行いました。

# gpart create -s gpt /dev/ada0この後、スワップ領域を確保します。今回は 20GB ほど確保しました。

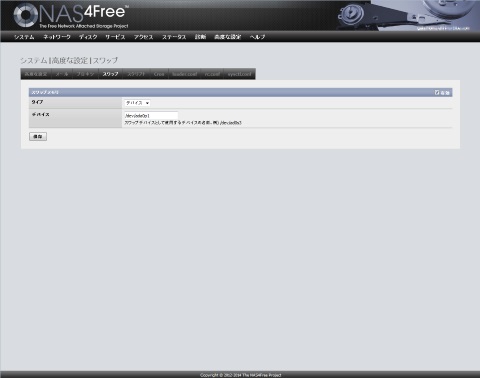

# gpart add -a 4k -s 20G -t freebsd-swap ada0以上の作業が終わったら、NAS4Free の GUI 管理画面にログインして、 「システム」メニューの「高度な設定」から「スワップ」タグを選んで、 スワップを「有効」にしてタイプで「デバイス」を選び、「デバイス」で「 /dev/ada0p1 」を指定します。

# 上記で SSD 上に作成した領域が最初のパーティション ( ada0p1 =デバイス ada0 の 1st パーティション p1 )の場合です。

それから「保存」を押せば作業は完了です。 ここまでの作業が終わるとコマンドラインから swapinfo コマンドで、 スワップが有効になっていることを確認できます。

# swapinfo -h Device 1K-blocks Used Avail Capacity /dev/ada0p1 20971520 0B 20G 0%さてこれでスワップの有効化は完了です。

次はいよいよ ZIL/L2ARC の設定を行います。